據外媒Venturebeat報道,Facebook、喬治亞理工學院和俄勒岡州立大學的研究人員在本周發表的一篇預印本論文中,描述了人工智能的一項新任務——通過聽自然語言的指令,在3D環境中導航(例如,“走下大廳,在木桌旁左轉”)。他們說,這可以為遵循自然語言指令的機器人助手奠定基礎。

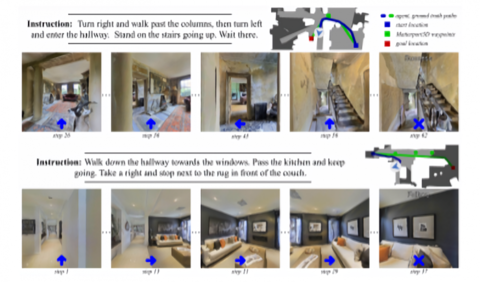

研究人員的任務,被稱之為在連續環境中的視覺和語言導航(VLN-CE),是在Facebook的模擬器Habitat中進行的,該模擬器可以訓練機器人助手在模擬真實環境的環境中操作。直徑為0.2米、1.5米高的助手被放置在來自Matterport3D數據集的內部,該數據集是通過10800多個全景圖和相應的3D網格捕獲的90個環境的集合。

機器人助手必須在一條路徑上做四個動作(向前移動0.25米,左轉或右轉15度,或停在目標位置)中的一個,并學會避免被困在障礙物上,比如椅子和桌子上。

研究小組將這些環境提煉成4475條由4到6個節點組成的軌跡,這些軌跡對應于在各個位置拍攝的360度全景圖像,顯示了導航能力。

他們用這個訓練兩個人工智能模型:一個sequence-to-sequence模型,該模型由采取視覺觀察和指令表示的策略組成,并使用它們預測一個動作;另一個是兩個網絡交叉模式注意模型,該模型跟蹤觀察結果,并根據指令和特征做出決策。

研究人員表示,在實驗中,表現最好的機器人可以遵循“向左拐,進入走廊”之類的指令,盡管這些指令要求機器人在發現視覺路標之前轉動未知的次數。事實上,機器人在看不見的環境,大約三分之一的場景中導航到目標位置,平均采取了88次行動。

這些機器人偶爾也會失敗,根據合著者的說法,這些失敗通常是由于機器人在視覺上丟失了指令中提到的對象。

“至關重要的是,VLN-CE為(研究)社區提供了一個測試平臺,在這里可以進行研究高級和低級控制界面的這類集成實驗,”合著者寫道。

Facebook投入了大量資源來解決自主機器人導航的問題。

今年6月,在公布了一項訓練六足機器人走路的計劃后,Facebook首次推出了PyRobot,一種用于PyTorch機器學習框架的機器人框架。2018年,Facebook推出了開源人工智能,可以通過360度圖像在紐約市街道上導航。最近,Facebook的一個團隊發表了一篇論文,描述了一個通過觀看視頻學習如何在辦公室里走動的系統。(來源雷鋒網)